深度学习的基本数据结构之一是张量(Tensor),在PyTorch中扮演着至关重要的角色。本文将从三个方面介绍PyTorch中张量的基础概念、原理以及常见操作,旨在为读者提供清晰的指导和帮助。

张量是一种多维数组,包括标量(零维数组)、向量(一维数组)、矩阵(二维数组)以及具有更高维度的数组。在PyTorch中,张量是torch.Tensor的实例,可以通过多种方式创建。

import torch

# 创建一个标量

scalar_tensor = torch.tensor(3.14)

# 创建一个向量

vector_tensor = torch.tensor([1, 2, 3])

# 创建一个矩阵

matrix_tensor = torch.tensor([[1, 2, 3], [4, 5, 6]])

# 创建一个3D张量

tensor_3d = torch.rand((2, 3, 4)) # 2行3列4深度

每个张量都有关键属性,包括形状(shape)、数据类型(dtype)和设备(device)。

# 获取张量的形状

shape = tensor_3d.shape

# 获取张量的数据类型

dtype = tensor_3d.dtype

# 获取张量所在的设备

device = tensor_3d.device

张量的形状定义了其维度和每个维度上的大小,对于理解和操作张量至关重要。

# 获取张量的形状

shape = tensor_3d.shape

# 改变张量的形状

reshaped_tensor = tensor_3d.view(3, 8) # 将原始形状(2, 3, 4)变为(3, 8)

PyTorch中的张量是基于Tensor类实现的,主要包括存储(storage)、形状(shape)和步幅(stride)三个主要组件。

存储是实际存储数据的地方,是一块连续的内存区域,多个张量可以共享相同的存储以减少内存消耗。

# 获取张量的存储

storage = tensor_3d.storage()

形状定义了张量的维度和每个维度上的大小,有助于理解存储中数据的组织方式。

# 获取张量的形状

shape = tensor_3d.shape

步幅是在存储中移动到下一个元素所需的步数,有助于理解张量中的索引和切片性能。

# 获取张量的步幅

stride = tensor_3d.stride()

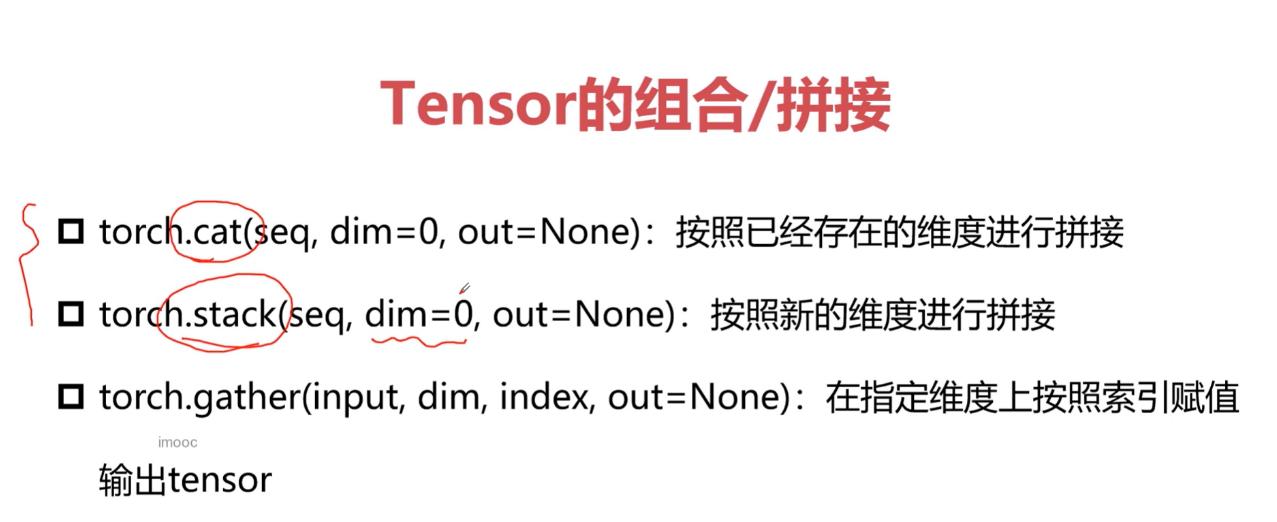

PyTorch提供了丰富的张量操作,包括数学运算、逻辑运算、索引和切片等。

# 加法

result_add = tensor_3d + 2

# 乘法

result_mul = tensor_3d * 3

# 矩阵乘法

matrix_a = torch.rand((2, 3))

matrix_b = torch.rand((3, 4))

result_matmul = torch.mm(matrix_a, matrix_b)

# 大小比较

result_compare = tensor_3d > 0.5

# 逻辑运算

result_logical = torch.logical_and(result_add, result_compare)

# 索引

element = tensor_3d[0, 1, 2]

# 切片

sliced_tensor = tensor_3d[:, 1:3, :]

# 改变形状

reshaped_tensor = tensor_3d.view(3, 8)

# 转置

transposed_tensor = tensor_3d.transpose(0, 2)

广播是一种自动扩展张量的操作,使得形状不同的张量可以进行逐元素的数学运算。

# 广播

tensor_a = torch.rand((1, 3, 1))

tensor_b = torch.rand((2, 1, 4))

result_broadcast = tensor_a + tensor_b

本文介绍了PyTorch中张量的基础概念、原理以及常见操作。张量作为深度学习中的基本数据结构,对于理解和实现神经网络至关重要。希望这些内容能够为大家在使用PyTorch时提供一些实用的帮助!