引言

近年来,随着人工智能技术的迅猛发展,SadTalker作为一项颇具创新性的技术应运而生。该技术以其能够根据一张图片和一段音频合成具有面部表情的语音视频而备受瞩目。本文将对SadTalker进行深入解析,介绍其背后的原理和应用。

SadTalker概述

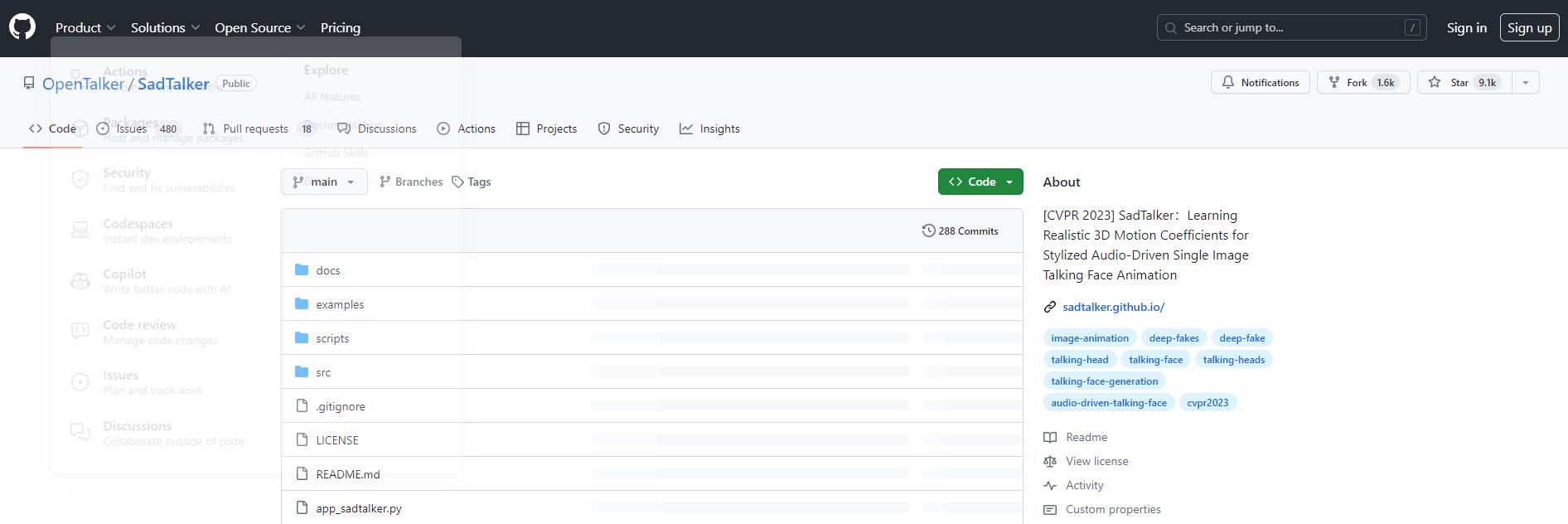

SadTalker是一项基于稳定扩散(Stable Diffusion)技术的开源项目,其官方网站为 SadTalker官网。该项目是由西安交通大学、腾讯AI Lab和蚂蚁集团共同发布的,作为CVPR 2023论文的开源实现。

技术原理

SadTalker的核心技术在于通过深度学习模型,结合一张图片和一段音频,实现对虚拟人物的面部表情和语音的合成。这项技术采用稳定扩散方法,有效地融合了图像处理和语音合成领域的先进技术。

使用方法

SadTalker的使用相对简便,用户可以直接在稳定扩散平台上应用该技术。通过提供一张图片和相应的音频,即可生成具有逼真面部表情和对应语音的合成视频。这为用户提供了一种全新的数字人物创作体验。

应用领域

SadTalker的应用领域广泛,可用于数字娱乐、虚拟主持人制作等方面。其创新性的技术为虚拟形象的表达提供了更加生动和个性化的方式,拓展了人工智能在创意产业中的应用。

开源社区参与

作为开源项目,SadTalker鼓励广大开发者参与贡献。开放的 GitHub地址 提供了详细的文档和代码,使开发者能够深入了解其实现原理,并为其不断的改进和发展贡献自己的力量。

结语

SadTalker的出现为虚拟人物技术注入了新的活力,其在图像处理和语音合成领域的应用前景令人振奋。随着开源社区的不断壮大,相信SadTalker在未来会有更多令人期待的发展,为数字创意产业带来更多可能性。

相关导航

暂无评论...