AnimaDiff:将静态图片转化为动态动画

简介

AnimateDiff是一款能够将静态图片转化为动态动画的工具。它适用于各种类型的图片,并且无需进行特定的调整。通过预训练的运动建模模块,它可以直接将个性化的文本到图像(T2I)模型转化为动画。该方法还可以推广到3D卡通和2D动画领域。AnimateDiff为个性化动画生成提供了简单而有效的基线。要使用AnimateDiff,您需要安装Stable Diffusion(SD)插件和AnimateDiff模型。

AnimateDiff的工作原理

AnimateDiff利用控制模块来影响Stable Diffusion(SD)模型。它通过大量的短视频剪辑进行训练。控制模块可以调节图像生成过程,以产生一系列外观类似于其所学习的视频剪辑的图像。简而言之,SD模型的训练是通过大量图片进行的,而AnimateDiff则是通过大量短视频来训练图片之间的衔接,即视频帧的流畅性。结合SD模型,在生成图像时,可以通过AnimateDiff模型微调每张图像,最终拼接成短视频。

AnimateDiff的优势

AnimateDiff提供了更优质的动画生成体验。随着文本到图像模型和个性化技术的进步,每个人都能以较低的成本将他们的想象力体现为高质量的图像。AnimateDiff在文生图模型中插入动作建模模块,用以避免破坏原有文生图微调模型生成能力,并在视频数据上学习合理的动作先验。在训练过程中,首先对模型结构进行了扩展,使其可以接受视频格式数据;同时在参数更新时保持原有文生图模型权重不变,使得训练后的网络权重可以即插即用地驱动不同版本的定制化微调模型,而无需针对相应模型做任何优化。在推理时,插入动作建模模块直接到相应定制化模型中,组合后的模型对采样的噪声序列去噪,生成相应的动画片段。

在AnimateDiff中,作者提出了一种将任何定制化文生图模型拓展用于动画生成的框架,可以在保持原有定制化模型画面质量的基础上,生成相应的动画片段。比如,为色彩斑斓的鹅卵石增添一些动态的光泽。

插件安装教程

Stable Diffusion插件的安装方法有以下三种:

- 在“Stable Diffusion”中点击“扩展”->“可下载”,再点击“加载扩展列表”,搜索关键词“AnimateDiff”,点击“安装”。安装完成后,重启“Stable Diffusion”即可。

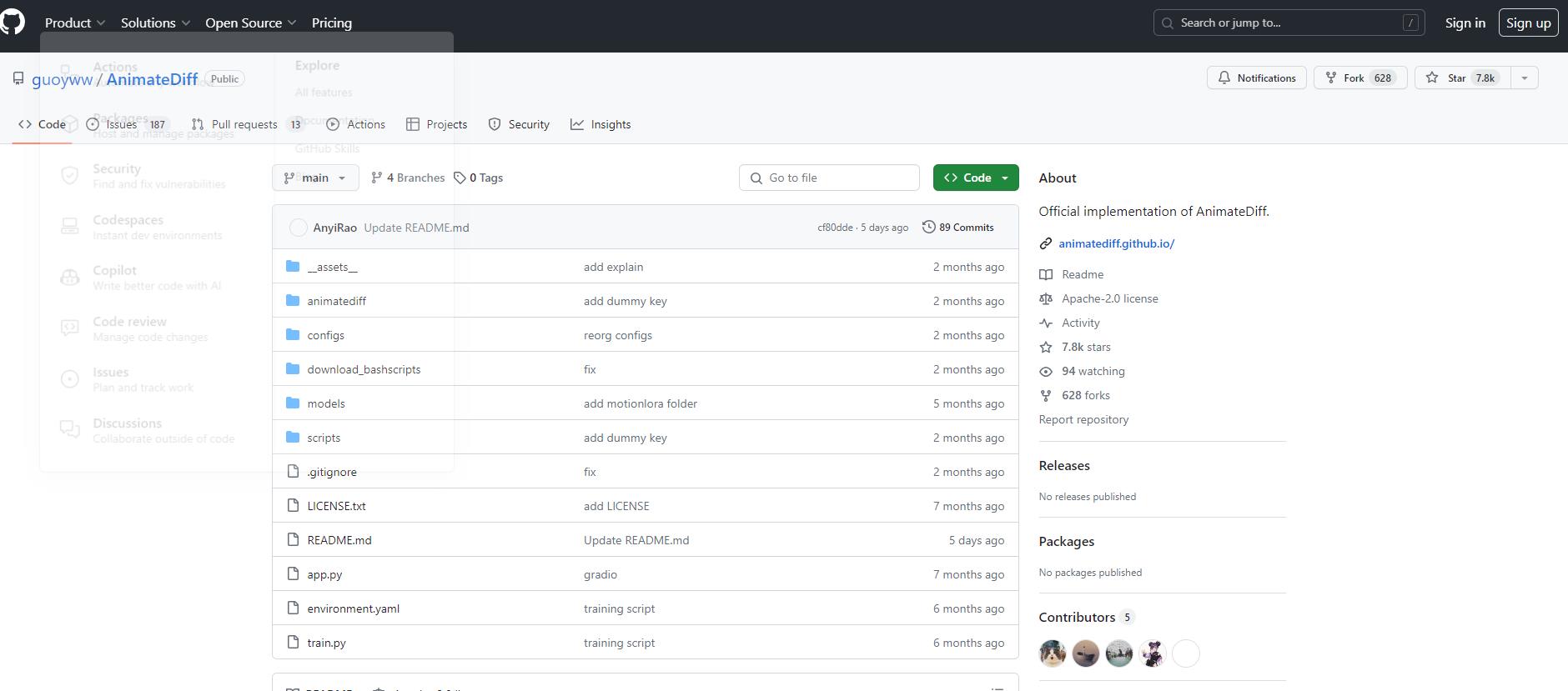

- 从网址安装,复制GitHub的URL,将插件的URL粘贴到“扩展的git仓库网址”上,然后点击“安装”。安装完成后,重启“Stable Diffusion”即可。

- 插件安装包安装,在GitHub下载该插件的安装包并安装到“Stable Diffusion”目录中的“extensions”文件夹中即可。(文末提供安装包)

模型下载

安装好插件之后,还需要下载一个动画模型和八个控制镜头的LoRA模型(控制镜头的模型可以不下载,但动画模型必须下载)。最新的动画模型是“mm_sd_v15_v2.ckpt”,它是最新且效果最稳定的版本。下载好模型后,将动画模型放入“.../sd-webui-aki-v4.2/extensions/sd-webui-animatediff/model”文件夹中,将LoRA模型放入“.../sd-webui-aki-v4.2/models/lora”文件夹中。

安装好插件并放置模型到对应文件夹后,重启Stable Diffusion,您就可以看到“AnimateDiff”插件了。

在线体验AnimateDiff

- 打开链接

- 先后选择Base DreamBooth Model与Motion Module(可跳过此步,直接使用默认配置,也可自行调整)

- 填写Prompt和Negative Prompt(示例见上文)

- 点击Generate,等待约一分钟,即可获得生成的动画视频。