去年12月,新架构Mamba在AI领域掀起了一场风暴,向一直占据主导地位的Transformer发起了挑战。如今,谷歌DeepMind推出的Hawk和Griffin为AI领域带来了新的选择。

谷歌DeepMind近日在基础模型方面又有了新动作。我们知道,循环神经网络(RNN)在深度学习和自然语言处理的早期发展中扮演了核心角色,并在诸多应用中取得了成功,包括谷歌的第一个端到端机器翻译系统。然而,近年来,随着Transformer架构的兴起,深度学习和自然语言处理领域的主流逐渐转向了Transformer,该架构融合了多层感知器(MLP)和多头注意力(MHA)。

Transformer在实践中表现出比RNN更好的性能,并且在利用现代硬件方面也非常高效。基于Transformer的大型语言模型在从网络收集的海量数据上进行训练,并取得了显著的成功。

尽管Transformer取得了巨大的成功,但其架构仍存在一些不足,例如由于全局注意力的二次复杂性,Transformer很难有效地扩展到长序列。此外,键值(KV)缓存随序列长度线性增长,导致Transformer在推理过程中变得缓慢。为了解决这些问题,循环语言模型成为了一种替代方案,它们可以将整个序列压缩为固定大小的隐藏状态,并进行迭代更新。然而,要想取代Transformer,新的RNN模型不仅必须在性能上达到相当水平,而且还必须具备类似的硬件效率。

在最新的一篇论文中,谷歌DeepMind的研究者提出了RG-LRU层,这是一种新颖的门控线性循环层,并围绕它设计了一个新的循环块来替代多查询注意力(MQA)。

他们使用这个循环块构建了两个新的模型,一个是混合了MLP和循环块的模型Hawk,另一个是混合了MLP、循环块和局部注意力的模型Griffin。

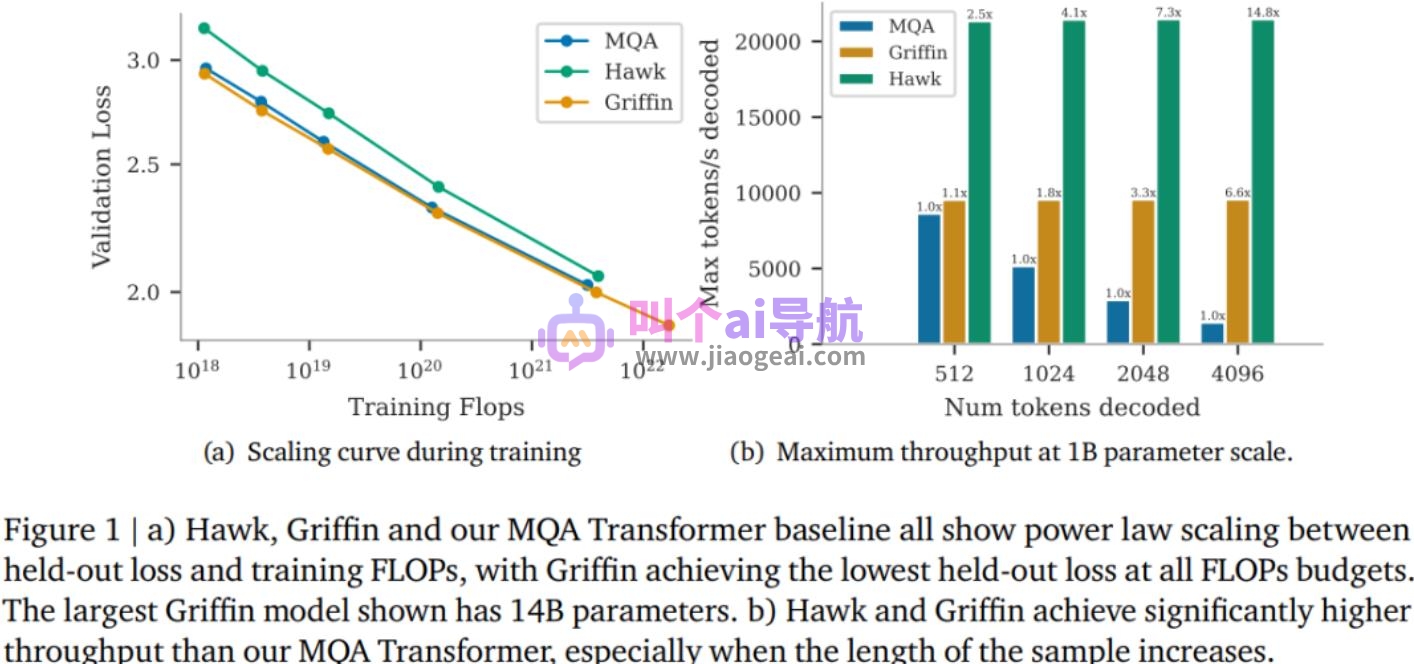

研究者表示,Hawk和Griffin在held-out损失和训练FLOPs之间表现出了幂律缩放,最高可达到7B参数,这与之前在Transformers中观察到的情况相似。其中,Griffin在所有模型规模上实现了比强大的Transformer基线略低的held-out损失。

研究者对Hawk和Griffin在一系列模型规模上进行了过度训练,结果显示,尽管Hawk-3B的训练tokens数量仅为Mamba-3B的一半,但在下游任务的性能上超越了后者。Griffin-7B和Griffin-14B的性能与Llama-2相当,尽管其训练tokens数量分别为后者的1/7。此外,Hawk和Griffin在TPU-v3上达到了与Transformers相当的训练效率。

在推理过程中,Hawk和Griffin实现了比MQA Transformer更高的吞吐量,并在采样长序列时实现了更低的延迟。在评估较长序列时,Griffin的表现比Transformers更好,并且可以有效地从训练数据中学习复制和检索任务。然而,在未经微调的情况下,在复制和精确检索任务上评估预训练模型时,Hawk和Griffin的表现不如Transformers。

共同一作、DeepMind研究科学家Aleksandar Botev表示,混合了门控线性循环和局部注意力的模型Griffin保留了RNN的所有高效优势和Transformer的表达能力,最高可以扩展到14B参数规模。