最新研究来自谷歌DeepMind,揭示了问题中前提条件呈现顺序对大模型推理性能的决定性影响,特别是在逻辑推理任务中。这项研究发现,打乱信息的顺序能使模型的表现下降高达30%。具体细节可在论文中查阅。

发现的关键点

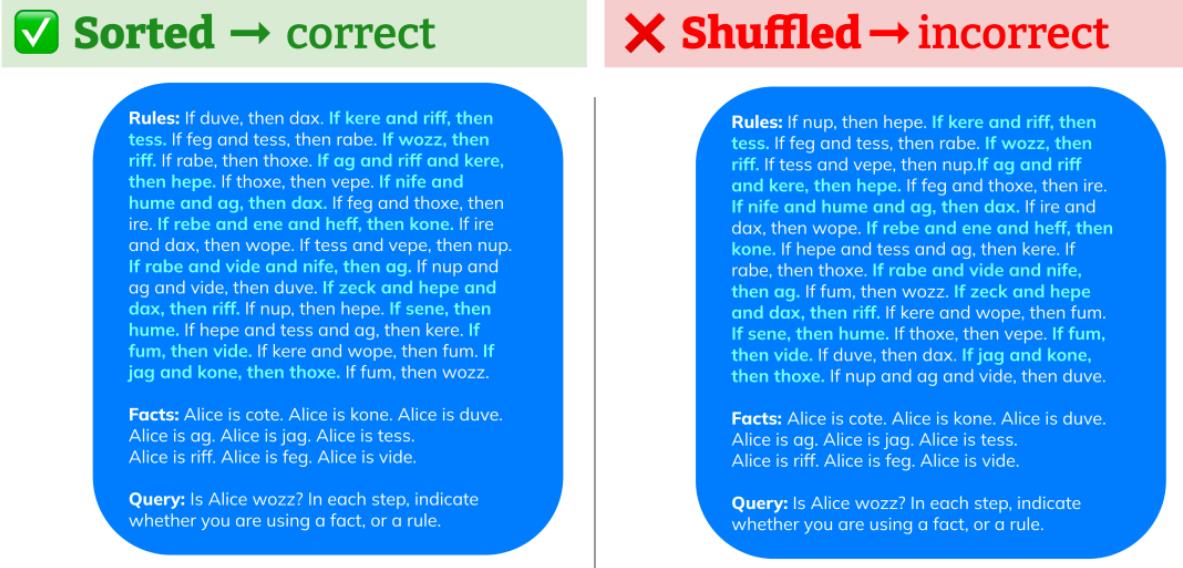

谷歌DeepMind和斯坦福的研究人员发现,在处理逻辑推理和数学问题时,当信息按照逻辑上的自然顺序排列时,大模型的表现更佳。举例来说,对于一个证明任务,如果条件按照1,2,3的顺序呈现,相比于2,1,3的条件呈现顺序,大模型的成功率会显著提高。

在实验中,研究人员改变了相关规则的顺序,涉及GPT-4、Gemini Pro和GPT-3.5等主流模型。结果显示,改变前提的叙述顺序会导致性能大幅下降。有趣的是,新型模型Gemini Pro和GPT-3.5-Turbo在下降趋势上几乎一致。

进一步的实验证明

研究人员构建了R-GSM测试集,通过打乱问题陈述顺序,观察模型的表现。结果显示,在这个打乱顺序的测试集中,几乎所有主流的大模型性能都出现了下降。尤其是,如果在逻辑推理任务中添加了分散注意力的规则,打乱前提会导致更大的准确性下降。

挑战和未来方向

虽然人类在解决逻辑问题时也对前提顺序有偏好,但大模型更容易受到这种顺序效应的影响。研究人员认为这可能与自回归模型训练目标和/或训练数据中的偏差有关。然而,如何应对这个问题仍然是一个有待进一步研究的挑战。

总体而言,以后在使用大模型进行逻辑推理时,言简意赅、符合逻辑地提出问题将有助于提高模型性能。对于开发者和研究人员来说,了解前提顺序效应的影响是优化大模型性能的关键一步。

暂无评论...