研究团队认为,稀疏专家多模态大模型与通用专家模块的巧妙组合,不仅成功缓解了任务之间的冲突,而且确保了稀疏模型对任务的泛化能力,使得多模态大模型能够更有效地适配不同的下游行业应用。

任务冲突的挑战

然而,近期的研究表明,在对多模态大模型进行“多任务指令微调”时,可能会遇到一个“学得多错得多”的问题。这是因为不同任务之间存在冲突,导致模型的泛化能力下降。举例来说,多模态问答任务可能要求简洁准确的回答,而文档理解任务则可能要求大模型做出更为详细的描述。

问题解决的思路

为了解决这一问题,来自香港科技大学、南方科技大学和华为诺亚方舟实验室的联合研究团队提出了一种创新性的解决方案。受到混合专家模型(MoE)开源大模型Mixtral-8×7B的启发,他们提出了利用稀疏专家模型的方法,以构建下游任务泛化性能更强、理解能力更强的多模态大模型。

基于指令聚类的稀疏专家多模态大模型

数据划分与微调

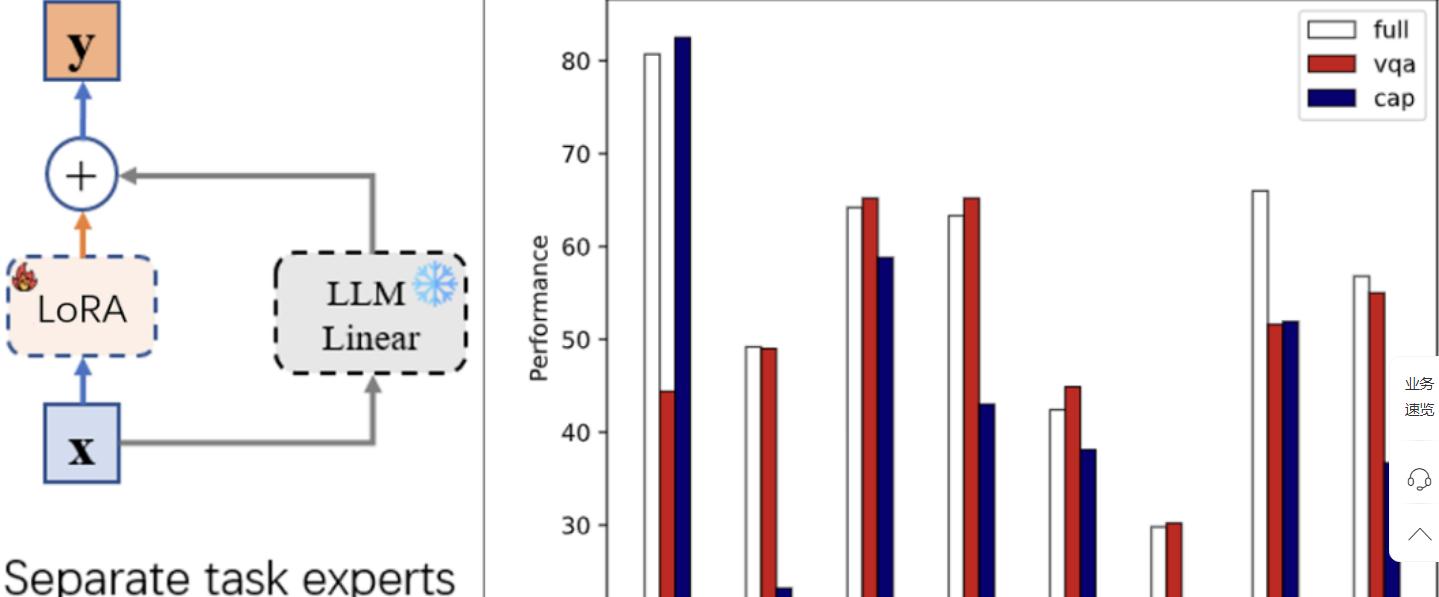

为了验证多模态指令微调中不同类型任务数据对模型性能的影响,研究人员将数据划分为VQA(视觉问答)、Captioning(图像描述)和Full(所有数据)三个类别。通过对InstructBLIP进行LoRA微调,研究人员得到了3个专家模型,并在其他数据上进行零样本测试和评估。

指令聚类优势

通过使用Kmeans将所有的指令聚为64类,研究人员有效地避免了人工划分数据的成本。这样的指令聚类信息被用于混合LoRA专家路由,使得模型在处理不同任务时能够更加智能地选择路由,从而避免了多模态指令微调中存在的任务冲突问题。

通用专家的引入

虽然指令聚类LoRA专家缓解了任务冲突,但研究团队发现,由于一个专家可能只见过一部分任务,整个模型对下游任务的泛化性能降低。为了解决这一问题,他们引入了通用专家,该专家能够从所有数据中学习指令的泛化能力,弥补了任务专家的局限性。

实验效果与结论

研究团队在13个训练数据集上进行了指令微调,并在11个测试数据集上进行了评估。实验证明,引入他们提出的方法(MoCLE)后,InstructBLIP在所有下游任务上都取得了提升。尤其在VSR、IconQA、TextVQA等任务中,提升效果尤为显著。

通过可视化结果,研究团队展示了在不同数据下的混合LoRA专家的路由效果。使用指令聚类信息路由时,任务专家之间出现了明显的分化,使得每个专家更专注于特定类型的任务,进一步提高了模型的泛化性能。

总体而言,研究团队的创新性工作在多模态大模型的设计中引入了稀疏专家和通用专家的思想,成功应对了任务冲突带来的挑战,为模型在不同行业应用中的适配提供了更为有效的解决方案。