近期,小型语言模型正掀起一股热潮,Mistral和微软纷纷加入这场风潮。令人惊讶的是,Mistral-medium的代码能力竟然在成本不到GPT-4三分之一的情况下超越了后者。这使得小语言模型成为近期的热门话题。

Mistral的创新之举

法国AI初创公司Mistral在完成4.15亿美元融资后,宣布推出了Mixtral 8x7B模型。尽管这个开源模型的尺寸相对较小,足以在内存100GB以上的电脑上运行,但在某些基准测试中,它能与庞大的GPT-3.5相媲美,因此迅速赢得了开发者的好评。

这一模型之所以被称为Mixtral 8x7B,是因为它巧妙地结合了多个较小模型,专门训练用于处理特定任务,从而提高了运行效率。这种"稀疏专家混合"模型的实现并非易事,据说OpenAI早些时候曾因无法让MoE模型正常运行而放弃了相似的开发尝试。

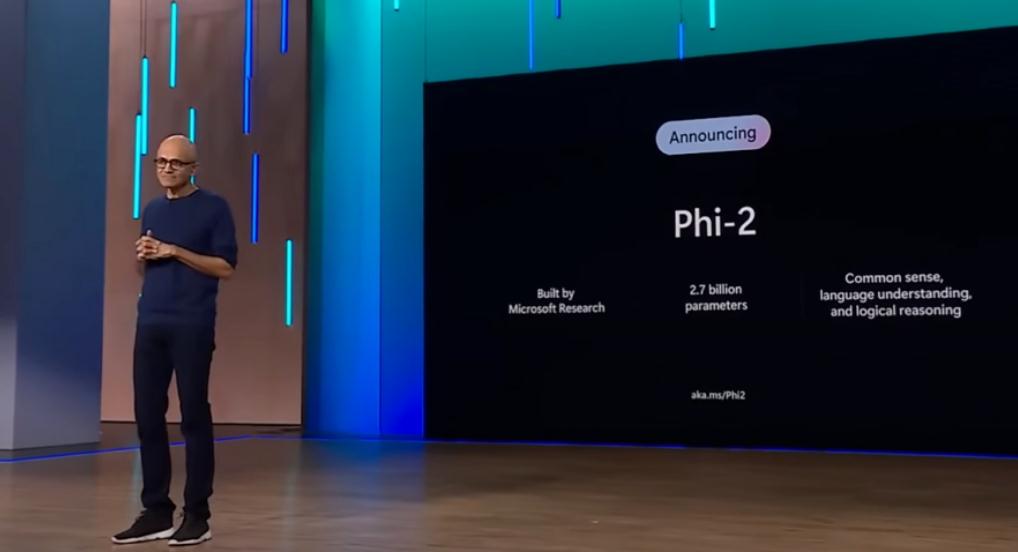

微软的回应:Phi-2小模型

随后,微软也迅速跟进,发布了Phi-2小模型。相较于Mistral的70亿参数,Phi-2仅有27亿参数,足够小到可以在手机上运行。与此同时,GPT-4的参数数量已经高达一万亿。

Phi-2经过在精心挑选的高质量数据集上的训练,即使在计算能力有限的手机上,也能保证生成准确的结果。尽管目前尚不清楚微软及其他制造商将如何利用这类小型模型,但最明显的好处是降低了大规模运行AI应用的成本,并极大地拓宽了生成式AI技术的应用范围。

Mistral-medium的惊人表现

Mistral-medium最近宣布开始内测。一位博主进行了Mistral-medium和GPT-4代码生成能力的比较,结果显示Mistral-medium不仅在代码能力上胜过GPT-4,而且成本仅为GPT-4的三成。

总体来说,Mistral-medium的优势表现在:

- 始终高效完成任务;

- 不浪费token在冗长的解释性输出上;

- 提供具体而实用的建议。

举例来说,在编写用于生成斐波那契素数的PyTorch数据集的cuda优化代码的任务中,Mistral-Medium生成的代码严肃、完整,而GPT-4生成的代码则显得差强人意。

同样,对于编写高效的Python代码,将大约10亿个大型Apache HTTP访问文件摄取到SqlLite数据库中,并生成对sales.html和product.html的访问直方图的任务,Mistral的输出非常出色,而GPT-4则表现平平。

这位博主之前一直认为GPT-4在代码生成方面稳居第一,然而,Mistral-medium以强大的性能终于打破了这一格局。尽管只提供了两个例子,但在多个测试问题中,Mistral-medium都展现出了相近的优异表现。鉴于其在代码生成质量上的优越体验,有人建议将Mistral-medium整合到各种代码copilot中。

有人根据每1000个token的成本计算,发现Mistral-medium的成本比GPT-4降低了70%。这不仅是一项重大进展,更是为优化成本提供了新的思路。通过减少冗长的输出,Mistral-medium在节省token费用上取得了巨大的成功。

综合来看,小语言模型的崛起不仅在技术上展现了创新,更在经济上为AI应用的普及带来了新的可能性。未来,我们或许将看到更多公司和研究机构在小型模型领域取得突破,推动人工智能技术的快速发展。