随着最新一代的GPT-4 Turbo的问世,ChatGPT再次掌握了大模型排行榜的领先地位,超越了Claude 3 Opus。而且,这一新模型在处理长达64k长度的输入时,性能更胜旧版在26k时的表现。从今天起,最新版的GPT-4 Turbo正式向ChatGPT Plus用户开放!

此外,根据OpenAI的介绍,GPT-4 Turbo在回复时更加直接,减少了啰嗦内容,更加口语化。

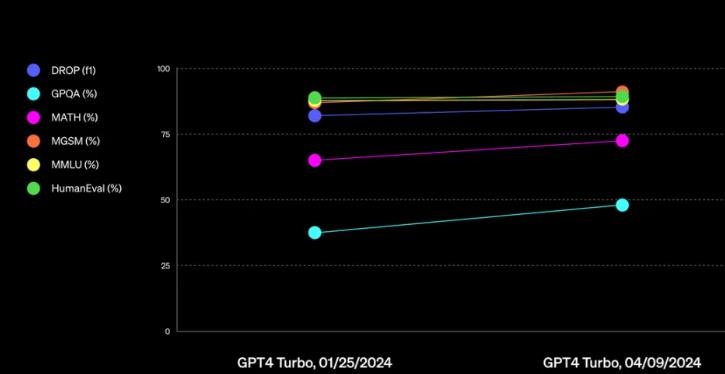

我们一起来看看,在基准测试中,GPT-4 Turbo的表现如何呢?

- 数学性能提升近10%

- 在官方公开的GitHub上,OpenAI发布了最新的gpt-4-turbo-2024-04-09的评估结果。

- 主要对模型在以下七大基准上进行了评估:MMLU(多任务语言理解)、MATH(数学问题解决能力)、GPQA(谷歌防护问答基准)、DROP(段落离散推理的阅读理解基准)、MGSM(多语言小学数学基准)、HumanEval(代码训练的大型语言模型评估)、MMMU(专家通用人工智能理解和推理基准)。

- 在这个GitHub库中,OpenAI主要使用零样本、CoT设置,并采用简单的指令,如“解决以下多项选择题”,以更真实地反映模型在实际使用中的表现。

- 根据具体结果显示,最新的gpt-4-turbo在数学方面的能力实现了近10%的提升。

- 而在整体的比较中,新模型基本上实现了对Claude 3 Opus和Gemini Pro 1.5的全面超越。

在大海捞针测试中,最新的gpt-4-turbo也全方位地超越了此前的1106-preview。

众所周知,上下文越长,对模型的挑战就越大。

而gpt-4-turbo在处理长达64k Token的内容时,性能直接媲美预览版在26k Token时的表现。

如果回顾一下GPT-4刚发布时的情况,也就是大约一年之前,最新的gpt-4-turbo在32k的配置下,性能比初代GPT-4提高了约4.3倍。

在前段时间,Anthropic手里的最强大模型Claude 3 Opus霸榜各大榜单。

不过,就在今天,OpenAI凭借着全新的gpt-4-turbo,再次超越了Claude 3,夺得第一。

根据LLM排位赛的最新结果,GPT-4-Turbo再次超越Claude 3,夺得第一。

LMSYS Org从多个领域收集了超过8000张人类投票,发现GPT-4-Turbo在编程与推理方面的表现,超越了其他模型。

为了深入了解,研究人员在Arena引入了“类别”功能。

通过这一新功能,可以对编程、长查询处理和多语言能力等不同领域进行更详尽的比较。

研究人员还对编程领域中包含代码片段的所有对话进行了标记。在这一方面,GPT-4-Turbo展现出更强的性能。

类似的,Naman Jain也发现,新版GPT-4-Turbo在LiveCodeBench(包含编程竞赛题)上的表现,提高了惊人的4.5分。

这类问题对目前的LLM来说挑战很大,而OpenAI此次的更新,明显是大幅提升了模型推理能力。

在长查询领域(Token数量超过500),Claude-3 Opus表现最佳。

令人有些意想不到的是,Command R/R+在这一领域中也有着非常高的得分。

有趣的是,如果只涉及英语提示,排名会与整体略有不同。

在这一类别中,三种GPT-4-Turbo依然处于领先地位。

而这种变化的产生,是因为随着用户基数的扩大,语言使用从英语转向包括中文在内的多种语言。