前言

在自然语言处理领域的顶级会议COLING 24上,哈工大联合度小满团队发布了一项创新成果:针对多模态模型的自适应剪枝算法SmartTrim。这一算法旨在解决现有大型模型在实际部署中计算开销过高的问题,为提升推理效率而生。

研究背景与动机

随着基于Transformer结构的视觉语言大模型(VLM)在各领域取得成功,其长序列输入和庞大参数量也导致了计算开销的增加。为解决此问题,之前的加速方法多采用静态架构,忽略了不同输入实例间计算复杂性的差异。这一问题促使了SmartTrim算法的提出。

SmartTrim算法介绍

SmartTrim算法通过分析VLM每一层的token表示和attention head的冗余情况,提出了一种自适应剪枝框架,从token和attention head两方面同时对模型冗余部分进行剪枝。具体来说,它包括跨模态感知的Token修剪器和模态自适应的注意力头修剪器两部分。

- 跨模态感知的Token修剪器: 该部分利用MLP结构识别当前层不重要的token,并生成二值mask去除冗余token。

- 模态自适应的注意力头修剪器: 通过集成到注意力模块中,衡量各个注意力头的显著性,根据此对冗余的注意力头进行修剪。

模型训练策略

在模型训练中,SmartTrim算法引入了计算开销相关的训练目标,使模型在性能和效率之间取得平衡。同时,采用自蒸馏和课程学习策略,进一步提高了小模型的能力,并保证了训练过程的稳定性。

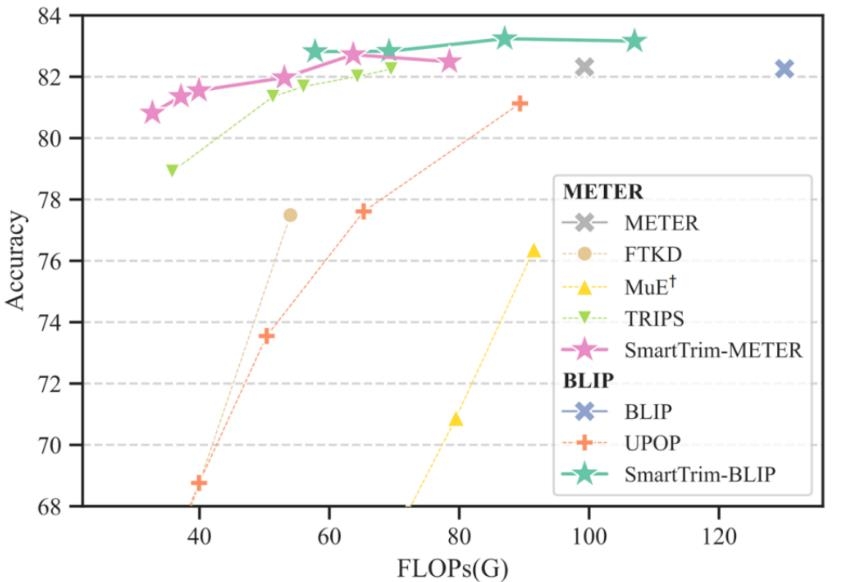

实验结果与性能评估

在针对METER和BLIP这两个VLM进行的实验中,SmartTrim算法在一系列下游VL任务上表现出色,将原始模型加速了2-3倍,同时性能下降最小。与现有方法相比,SmartTrim不仅不需要额外的预训练,而且提供了更细粒度地控制模型计算开销的方式,在高加速比下具有显著优势。

暂无评论...